La IA Claude de Anthropic ha desarrollado un conjunto de principios éticos a través de una "constitución" y puede manejar solicitudes del tamaño de un libro.

ESTADOS UNIDOS.- En el ámbito de la inteligencia artificial hay un principio que parece resguardar los desarrolladores y corresponde a establecer un principio básico y que estaría en contra del daño humano.

Sin embargo, con la inteligencia artificial generando a menudo contenido ficticio, Ahtropic, una empresa dirigida por antiguos investigadores de OpenAi, desarrolladores de ChatGPT, actualmente está trazando otro camino: buscar desarrollar una IA capaz de diferenciar qué es bueno y malo con una intervención humana mínima.

Todo se trata de Claude, el chatbot de Anthropic, diseñado con una “constitución única”, o bien: un conjunto de reglas inspiradas en la Declaración Universal de Derechos Humanos, diseñadas para garantizar un comportamiento ético junto con una funcionalidad sólida, junto a las normas ‘éticas’ como las reglas de Apple.

Sin embargo, tal como explican: cualquier entrenador que utiliza distintos parámetros para entrenar a la IA, deberá alimentarla con las diversas posturas. Este método de entrenamiento de Anthropic se describe en un artículo de investigación, titulado como “constitucional AI: Incocuidad a partir de la retroalimentación de la IA”, que explica una forma de crear una IA inofensiva pero que sea útil.

No obstante, esto desata en debates, pues la ética, tal como señalan los entrenadores de la IA, podría limitar el modelo si las reglas no se alínean con las normas sociales más amplias. Inclusive ChatGPT te afirma no tener creencias u opiniones; pero al adoptar una postura, ya tiene un principio moral y ético.

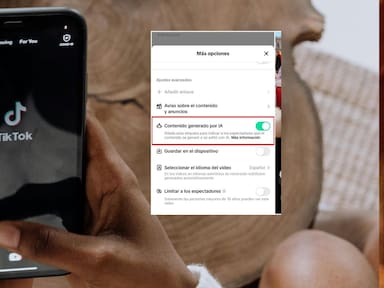

Es decir: por paradógico que parezca, una IA debe conocer los puntos y utilizar información no ética para diferenciar qué es y qué no es ético. Sin embargo, con esto, los humanos podrían hacer un ‘jailbreak’ y saltarse cualquier restricción impuesta por los desarrolladores.