Lo más llamativo del informe no fue su falta de veracidad, sino quién fue el autor detrás de esa ficción jurídica. El responsable no fue directamente Schwartz, sino la herramienta que utilizó para agilizar su investigación legal: ChatGPT. El abogado admitió que confió en esta IA de OpenAI, pero ahora reconoce su falta de fiabilidad.

La capacidad sorprendente de ChatGPT no sorprende en absoluto, ya que es capaz de aprobar exámenes universitarios y mejorar la productividad en las oficinas.

Sin embargo, también está lejos de ser infalible, como ha descubierto recientemente el abogado Steven A. Schwartz de Nueva York, de la peor manera posible: cometiendo un error profesional que lo ha dejado en evidencia ante el juez y enfrentándose ahora a una sanción, según lo revelado por The New York Times.

Todo esto ocurrió debido a la excesiva confianza depositada en la herramienta de OpenAI. Para entender lo sucedido, debemos remontarnos al 27 de agosto de 2019, a bordo de un avión de la aerolínea Avianca.

Ese día, Roberto Mata sufrió un golpe en la rodilla por parte de un carrito metálico manejado por uno de los asistentes de vuelo, lo cual lo llevó a presentar una demanda contra Avianca.

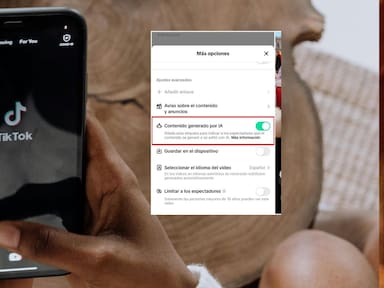

La IA es una herramienta

La compañía solicitó al juez federal de Manhattan que desestimara el caso, pero los abogados de Mata se opusieron firmemente. Para respaldar su argumento, el abogado Steven A. Schwartz, del despacho Levidow, Levidow & Oberman, elaboró un detallado informe de 10 páginas que incluía citas y referencias de precedentes judiciales.

Sin embargo, resultó que estas referencias eran más ficticias que legales, ya que los abogados de Avianca y el propio juez no pudieron encontrar ninguna de las mencionadas.

Lo más llamativo del informe no fue su falta de veracidad, sino quién fue el autor detrás de esa ficción jurídica. El responsable no fue directamente Schwartz, sino la herramienta que utilizó para agilizar su investigación legal: ChatGPT. El abogado admitió que confió en esta IA de OpenAI, pero ahora reconoce su falta de fiabilidad.

Este incidente ha desviado la atención del caso Mata vs Avianca hacia el manejo que Schwartz hizo de la inteligencia artificial y sus consecuencias desastrosas.

El juez P. Kevin Castel se encuentra ante una situación sin precedentes, con un informe legal plagado de referencias erróneas, incluyendo seis casos judiciales falsos con citas y referencias inventadas. Según The New York Times, se ha programado una audiencia para el 8 de junio, donde se discutirán las posibles sanciones.