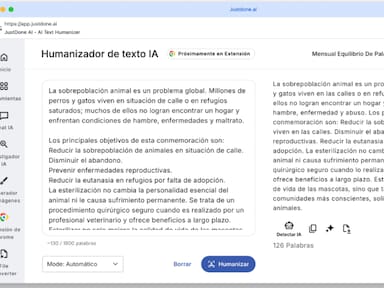

Uno de los errores más comunes al utilizar ChatGPT u otros sistemas similares es compartir información confidencial.

La interacción con sistemas de inteligencia artificial como ChatGPT ha transformado la forma en que las personas buscan información y resuelven tareas diarias. La posibilidad de obtener respuestas inmediatas y la diversidad de temas que abarcan han convertido a estas herramientas en un recurso frecuente dentro del entorno digital.

Sin embargo, expertos en ciberseguridad de WeLiveSecurity han advertido sobre riesgos importantes relacionados con la privacidad, la protección de datos y la calidad de la información obtenida.

De acuerdo con un artículo publicado en el sitio web Infobae, a medida que se incrementa el uso de asistentes de inteligencia artificial surgen interrogantes sobre los límites que los usuarios deberían fijar al emplear plataformas como ChatGPT. No toda la información es adecuada para ser consultada con estos sistemas, ya que algunas preguntas implican datos sensibles o requieren un grado de análisis que la IA no está en condiciones de proporcionar.

Estas son las cuatro consultas que no debes hacerle a ChatGPT.

Información personal: el principal riesgo

Uno de los errores más comunes al utilizar ChatGPT u otros sistemas similares es compartir información confidencial. Nunca deben ingresarse contraseñas, datos bancarios, números de identificación, información médica ni cualquier otro dato personal sensible.

Las conversaciones con inteligencia artificial no cuentan con cifrado de extremo a extremo, por lo que la información puede quedar expuesta a procesos internos de las plataformas o a posibles ataques externos.

Además, la gran popularidad de ChatGPT lo convierte en un objetivo atractivo para los ciberdelincuentes, quienes intentan acceder a cuentas, conversaciones y datos privados con fines fraudulentos o comerciales. Ningún sistema de inteligencia artificial garantiza una protección absoluta de la información compartida, por lo que los datos sensibles deben mantenerse fuera de estos entornos digitales.

Información empresarial y profesional: riesgos para organizaciones

El uso de la inteligencia artificial en el ámbito laboral exige una atención particular. No debe compartirse información perteneciente a una empresa, como informes financieros, bases de datos de clientes, estrategias comerciales o documentos confidenciales, ya que estos contenidos pueden almacenarse en servidores externos, sufrir filtraciones o quedar expuestos a usos no autorizados.

Consultas médicas, legales y financieras: límites del conocimiento

La inteligencia artificial puede ofrecer información de carácter general, pero no debe reemplazar la consulta con especialistas en ámbitos médicos, legales o financieros. Recurrir a ChatGPT para diagnósticos, tratamientos, interpretación de síntomas, decisiones legales o inversiones puede conducir a respuestas inexactas o incompletas, ya que la IA no dispone de la historia clínica ni del contexto personal de cada individuo.

Además, los sistemas de inteligencia artificial carecen de validez profesional y del criterio experto propio de médicos, abogados o asesores financieros. Tomar decisiones basadas en recomendaciones automatizadas puede tener consecuencias serias, por lo que es fundamental acudir siempre a profesionales certificados para tratar asuntos críticos en estas áreas.

La IA como “terapeuta”: límites en el acompañamiento emocional

Aunque la interacción con ChatGPT puede percibirse como natural, la inteligencia artificial carece de emociones, conciencia y experiencia personal. Consultar a la IA sobre opiniones, valores, preferencias o asuntos emocionales solo produce respuestas simuladas, basadas en patrones de lenguaje, sin una comprensión auténtica de la situación.

Las decisiones personales de relevancia deben apoyarse en familiares, amistades o profesionales capacitados. ChatGPT puede utilizarse como una herramienta inicial de orientación, pero no sustituye el acompañamiento humano ni la evaluación especializada en contextos emocionales complejos.